Le Défi des 100 jours de Ran.Données donne l’occasion aux participant.e.s de réaliser un projet d’analyse de données tout en développant de nouvelles habiletés. À chaque semaine, des ateliers et tutoriels sont organisés sur une variété de sujets : gestion de projet, visualisation de données et apprentissage machine.

POURQUOI 100 JOURS?

Organisé par l’Association des étudiant(e)s aux cycles supérieurs en bio-informatique de l’Université de Montréal (AÉBINUM) et IVADO, l’aventure se déroule de janvier à mai. Elle s’inscrit dans une initiative plus large visant à développer des talents à l’intersection des sciences de la vie et de l’informatique, un domaine en pleine effervescence. Il est recommandé de comptabiliser un minimum de 100 heures de travail sur 100 jours et d’y travailler au moins 5 jours par semaine. Lors de l’évènement de clôture, les participant.e.s recevront une attestation officielle d’IVADO et les meilleur.e.s d’entre eux/elles pourront remporter des prix.

Les participant.e.s fournissent les données et leur idée de projet, mais sont accompagné.e.s tout au long du défi via 13 ateliers et une communauté en ligne active. Aux yeux des organisateurs et organisatrices, ce support est primordial pour la complétion et la réussite des projets. J’ai été agréablement surprise de voir les internautes échanger régulièrement entre eux, se donner des conseils et même partager des offres d’emploi.

Atelier sur les bases de l’IA le 2 mars 2021

PRÉDIRE LE PRIX DE VENTE D’UN LOGEMENT AVEC L’IA

Durant la semaine de relâche, j’ai assisté à un atelier animé par Noël Rignon sur l’apprentissage automatique. Bachelier en génie logiciel à l’ÉTS, M. Rignon est également fondateur de deux entreprises dans l’industrie technologique : FJNR et Exo Free Motion. L’intelligence artificielle est née d’un besoin de traiter les données massives, avec l’objectif ultime d’aider la prise de décisions et résoudre des problèmes complexes. La quantité de données utilisées par les entreprises est au moins 1 000 fois plus importante qu’il y a 20 ans.

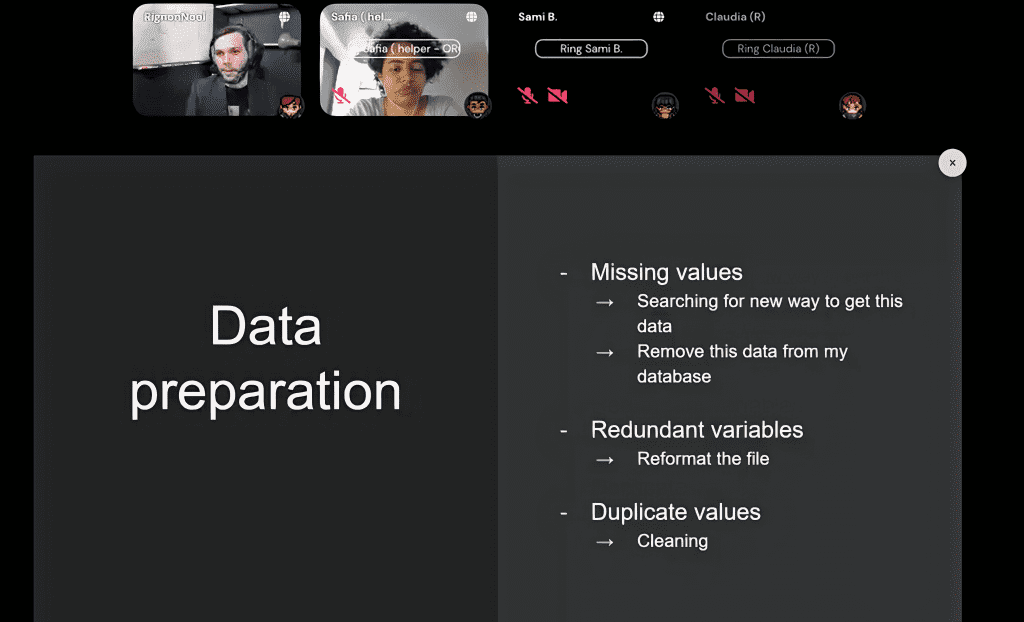

Supposons qu’un agent immobilier vous demande de déterminer le prix le plus approprié pour un logement. Après avoir clairement défini l’objectif, il faut trouver une source de données en lien avec le problème. Par exemple, on pourrait utiliser les prix de vente historiques pour des logements comparables ainsi que des informations sur le quartier et la construction de nouveaux logements. L’étape suivante consiste à nettoyer les données, c’est-à-dire identifier et corriger celles qui sont manquantes, redondantes ou dans un format inadéquat.

Vient ensuite l’étude exploratoire des données, où l’on teste des corrélations entre les variables (ex. : l’impact de la taille et de l’année de construction d’une maison sur son prix). Cette étape permet de cibler certains modèles prometteurs pour expliquer les données. Ensuite, on divise les données en 2 sous-ensembles : celui d’entraînement (80% des données) et celui de test (20% restant). Le modèle se sert des données d’entraînement pour trouver des attributs sur le jeu de données et ajuster certains paramètres internes. Le modèle est dit « généralisable » s’il performe bien sur des données inexplorées, les données de test. Dans notre exemple, plus la prédiction du modèle se rapproche du vrai prix de vente, plus il est performant.

En résumé, un projet en IA est divisé en 5 parties principales :

- Définition de l’objectif du projet

- Identification d’une source de données utile

- Nettoyage les données

- Étude exploratoire sur les données

- Choix du modèle au moyen de tests

« Je ne vois quasiment personne développer ses propres algorithmes, sauf dans les start-ups pour des cas très spécifiques » – Noël Rignon

L’APPRENTISSAGE AUTOMATIQUE… AUTOMATIQUEMENT!

Désormais, nombreuses sont les entreprises qui offrent des services clé-en-main pour des tâches de reconnaissance facile et vocale. Le client n’a qu’à fournir les données d’entraînement et en quelques secondes, on lui retourne les prédictions des meilleurs algorithmes. On nomme ce modèle d’affaires « Machine Learning as a Service », abrévié « MLaaS ». Un produit déjà très populaire est AutoML Tables de Google Cloud, présentement en version béta. J’ai hâte de voir comment l’industrie évoluera au cours des prochaines années. Des changements importants et excitants sont à prévoir!

![[J’ai testé pour vous] Défi des 100 jours de Ran.Données](https://www.cscience.ca/wp-content/uploads/2021/03/ilya-pavlov-OqtafYT5kTw-unsplash-1920x820.jpg)

![[Tournage d’un C+Clair] « Comment le génie révolutionne-t-il le sport ? » : Réservez votre place!](https://www.cscience.ca/wp-content/uploads/2024/03/emission-speciale-cclair-genium3-480x362.png)

![[Émission C+Clair] Maladies rares : comment optimiser les efforts de la recherche ?](https://www.cscience.ca/wp-content/uploads/2024/04/emission-maladies-rares3-480x362.jpg)