L’étude de l’Histoire exige une approche minutieuse des faits inoubliables. Or, les hypothèses sociales qui entourent les événements donnent lieu à différentes interprétations historiographiques. Aujourd’hui, les algorithmes dialoguent avec les sources sur lesquelles les historiens se basent pour faire ou défaire le passé. Cette discipline, parfois jugée poussiéreuse, opère pourtant un virage fondamental avec les humanités numériques. Arnaud Chaniac, doctorant à l’Université de Montréal, nous explique comment les sciences humaines nouent une relation intime avec l’IA. En d’autres termes, comment l’IA fait-elle son devoir de mémoire?

PROLOGUE

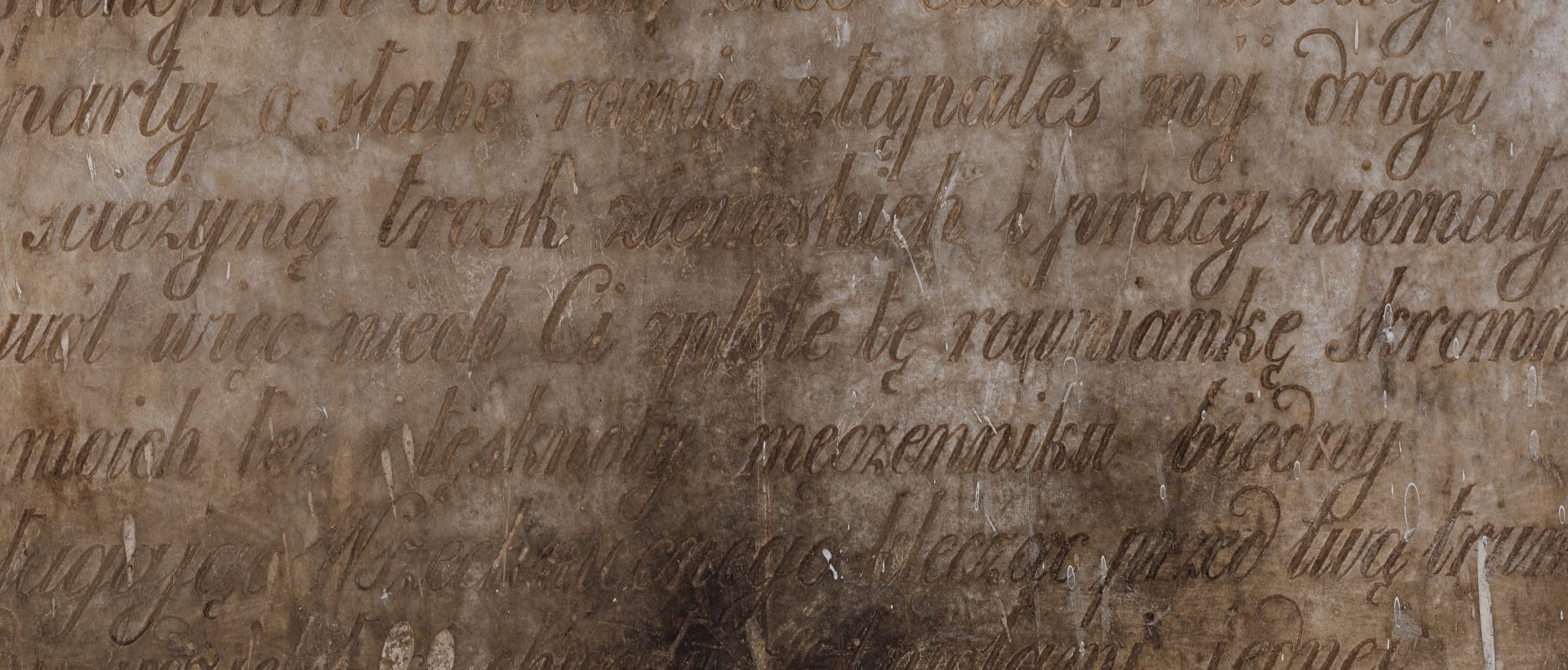

Les algorithmes et les ressources de calcul ouvrent de nouvelles perspectives dans l’univers de l’historiographie. Avant que les logiciels entraînés ne voient le jour, les historiographes cadraient leurs recherches par une lecture manuelle et donc chronophage. Aujourd’hui, des établissements publics tels que l’Institut national de recherche en sciences et technologies du numérique font de l’intelligence artificielle leur fer de lance. Les scientifiques ont assez de recul pour reconnaître l’efficience des interfaces dans le processus de récupération de textes manuscrits par exemple.

C’est grâce à la démocratisation de l’informatique que les logiciels ont commencé à s’imposer. Pierre Mounier, ingénieur de recherche à l’EHESS, explique que ces pratiques couvrent les étapes décisives allant de la recherche, la création, au traitement et à la valorisation de résultats. Selon lui, l’expression « Humanités numériques » (« Digital Humanities ») émerge comme un « big tent », un terme englobant un grand nombre d’usages et de techniques.

LES HUMANITÉS NUMÉRIQUES

Cette science auxiliaire donne l’avantage aux spécialistes de l’Histoire de construire des corpus avec une méthodologie pointue. Les algorithmes performants apportent un raffinement. Il existe de nombreuses interfaces, dont le logiciel de reconnaissance optique de caractères (OCR). Cela traduit les images de textes imprimés ou dactylographiés en fichiers de texte. Entraîné par la technique du deep learning, l’OCR marche sur le même principe que la reconnaissance d’images, sauf qu’on fonctionne par reconnaissance de caractères. Les humanités numériques utilisent au mieux les technologies de la gestion de données que nous offre l’ordinateur pour faire de la big data, gérer des quantités de données et établir des conclusions plus fermes d’un point de vue historique.

«L’utilisation des données numériques modifie la manière dont on produit le savoir». – Milad Doueihi, historien à la Sorbonne de Paris

Dans une conférence donnée par l’Université de la Sorbonne, le spécialiste des religions Milad Doueihi parle de “conversion” au sens technique du terme. Selon lui, on ne cesse de convertir les sources d’un format à un autre pour évoluer avec le progrès de la science informatique. Les capacités d’apprentissage de l’ordinateur sont simples à utiliser sur la partie syntaxique (construction de la langue). En revanche, la sémantique reste un frein à la modélisation des informations.

L’IA AU SERVICE DES SCIENCES HUMAINES

Les archives représentent la brique élémentaire dans laquelle le corpus scientifique réhabilite une cohérence de l’Histoire. Pour traiter ces fameuses sources, Arnaud Chaniac, doctorant et agrégé d’Histoire, utilise le logiciel de reconnaissance optique de caractères. Le développement de ce logiciel de textométrie progresse et devient influent peu avant les années 2000. Arnaud Chaniac travaille sur les correspondances de guerre entre le Canada et la France qui couvrent toute la période du XXe siècle. Afin d’optimiser ses recherches, il utilise un logiciel de lexicométrie. Le robot traite le corpus à sa place et met l’emphase sur les idées saillantes qui auraient pu passer sous le radar.

«L’IA est capable de nous fournir des outils performants pour avoir des données brutes, mais elle ne tire aucune conclusion». – Arnaud Chaniac, doctorant en histoire à l’UDeM

Si l’intelligence artificielle “océrise” l’ensemble de textes, elle est alors capable de révéler les unités syntaxiques qui reviennent. En effet, la machine repère un motif que l’œil humain n’a peut-être pas assimilé. En revanche, l’étape interprétative reste dans le domaine du chercheur. Il est le seul à posséder une connaissance du contexte et de la littérature scientifique. L’interprétation des faits n’est pas de son ressort, mais demeure celui du cerveau humain.

UN ENJEU DE TAILLE: L’INTERPRÉTABILITÉ

Baptisés “boîtes noires”, les modèles d’intelligence artificielle font désormais preuve de pertinence. Mais l’insuffisance de transparence liée au fonctionnement de ces modèles suscite tout de même un vrai scepticisme dans le grand public. L’interprétabilité des algorithmes suppose un enjeu éthique alors que l’intelligence artificielle influence de plus en plus de décisions du corpus scientifique. Laurent Romary, chercheur au CNRS, apporte son grain de sel cartésien à cette notion. Il questionne la nature de ces traces, l’impact que les résultats auront sur l’Homme.

« Notre société devrait intégrer l’informatique comme partie prenante de la formation nécessaire pour l’honnête Homme. » – Laurent Romary, chercheur au CNRS

Le prisme médical est tout à fait concerné par ce processus. Les professionnels de santé ainsi que les patients concernés doivent comprendre le cheminement des algorithmes ayant influencé une décision. La notion d’interprétabilité devient alors essentielle pour établir une relation de confiance entre l’intelligence artificielle et l’utilisateur.

Crédit photographique: Karolina Grabowska (Pexels)

![[Tournage d’un C+Clair] « Comment le génie révolutionne-t-il le sport ? » : Réservez votre place!](https://www.cscience.ca/wp-content/uploads/2024/03/emission-speciale-cclair-genium3-480x362.png)

![[Émission C+Clair] Maladies rares : comment optimiser les efforts de la recherche ?](https://www.cscience.ca/wp-content/uploads/2024/04/emission-maladies-rares3-480x362.jpg)