La multiplication des outils d’intelligence artificielle générative, accessibles aux usagers des quatre coins du monde, continue de soulever de nombreuses inquiétudes quant à leur manque d’encadrement. Devant l’urgence de mettre en place des mesures préventives en matière d’éthique et de sécurité, les gouvernements, organismes publics et entreprises privées du secteur des technologies s’allient pour emprunter rapidement cette voie.

Sept géants de la technologie, incluant Open AI, Amazon, Meta et Google, ont accepté les nouvelles mesures d’encadrement établies par la Maison-Blanche. Pendant ce temps, au Québec, on s’affaire à accélérer le développement de pratiques, systèmes et réglementations au bénéfice de l’IA de confiance.

Au Québec

Rappelons qu’à la mi-juin, au Québec, le Centre de recherche informatique de Montréal (CRIM) a annoncé qu’un investissement de 4,5 millions de dollars, octroyé par le ministère de l’Économie, de l’Innovation et de l’Énergie (MEIE), lui permettrait de piloter un consortium de recherche industriel sur l’IA de confiance.

Baptisé « Confiance IA », ce consortium a pour mandat de développer des pratiques et des outils concrets d’ingénierie pour concevoir des produits et systèmes industriels d’IA de confiance.

Le consortium vise à réaliser des projets industriels de plus de 40 millions de dollars au cours des prochaines années, et à soutenir des projets collaboratifs entre les acteurs majeurs du secteur industriel et technologique québécois.

« Un besoin criant se faisait sentir en matière de solutions d’ingénierie concrètes et compétitives utilisant l’IA de confiance pour les entreprises des secteurs réglementés. À ce titre, la vision du CRIM est celle de l’application d’une intelligence artificielle concrète et fiable qui répond aux réalités et aux besoins industriels, particulièrement ceux des PME. Confiance IA consiste justement à concevoir des solutions d’IA adéquates répondant aux besoins immédiats des partenaires industriels du programme, dans le but de créer une valeur socio-économique quasi-immédiate », a déclaré le président-directeur général du CRIM, Françoys Labonté.

« Un besoin criant se faisait sentir en matière de solutions d’ingénierie concrètes et compétitives utilisant l’IA de confiance pour les entreprises des secteurs réglementés. À ce titre, la vision du CRIM est celle de l’application d’une intelligence artificielle concrète et fiable qui répond aux réalités et aux besoins industriels, particulièrement ceux des PME. »

– Françoys Labonté, PDG du CRIM

« Grâce à des initiatives comme celle du CRIM, nous serons en mesure d’accélérer l’intégration de l’IA de confiance dans nos entreprises. L’acceptabilité sociale de l’IA représente, dans certains domaines, un défi qu’il faut relever avec des projets comme celui-ci », a quant à lui amené le ministre de l’Économie, de l’Innovation et de l’Énergie, Pierre Fitzgibbon.

Il y a quelques mois, le ministre a annoncé la constitution d’un forum de réflexion, coordonné par le Conseil de l’innovation du Québec (CIQ), et ayant pour mandat de définir un cadre éthique et responsable de l’IA, au travers de forums publics. Un appel aux contributions publiques sous forme de sondage, lancé par le CIQ il y a quelques semaines, a déjà permis de recueillir des recommandations qui orienteront l’ébauche de la réglementation québécoise quant à l’IA de confiance. D’ici là, le CIQ indique que « les travaux se poursuivent : nous analysons les contributions reçues et poursuivons les ateliers avec les experts identifiés. À l’automne 2023, un forum public sera organisé pour faire part de l’avancement des travaux et recueillir d’autres avis qui n’auraient pas été considérés jusqu’ici. Les informations concernant la tenue de ce forum public seront annoncées en septembre, sur le site web du Conseil de l’innovation du Québec et sur sa page LinkedIn. »

Des recommandations seront ainsi formulées au gouvernement du Québec vers la fin de l’automne 2023. Les conclusions du rapport seront publiés sur le site web du CIQ.

Aux États-Unis

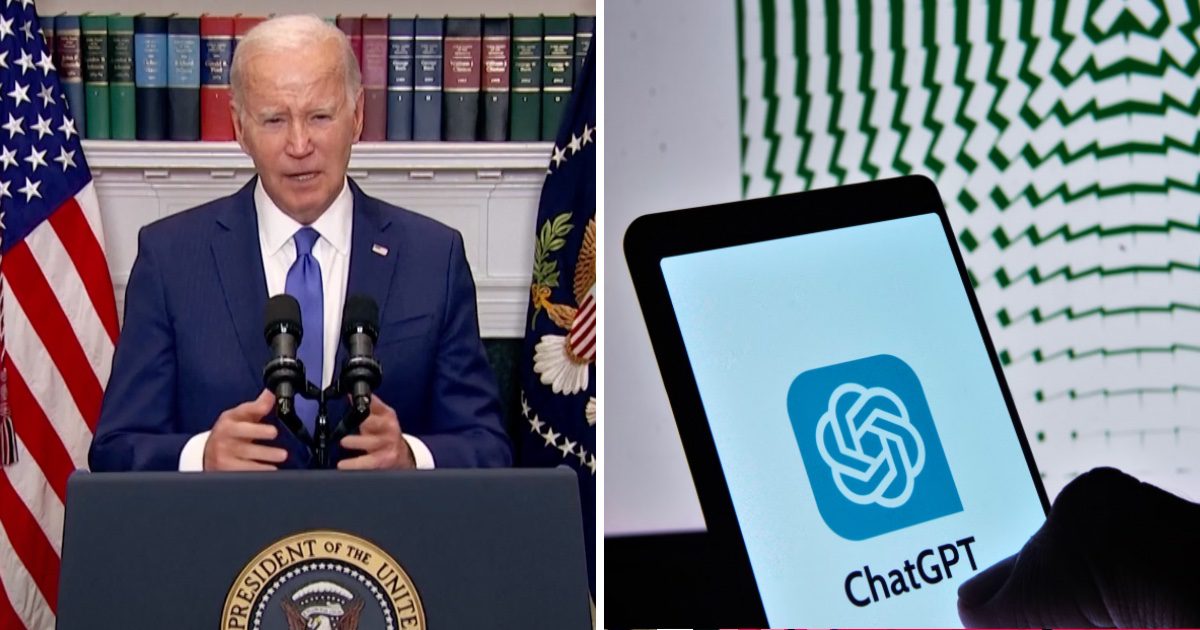

Un communiqué de la Maison-Blanche et une conférence de presse du président américain ont confirmé, vendredi dernier, que sept géants de la technologie et du web conviennent de respecter un ensemble de normes établies par l’administration du président Joe Biden, au bénéfice de l’IA de confiance. OpenAI, Amazon, Google, Meta, Microsoft, Anthropic et Inflection s’engagent ainsi à se conformer aux exigences de la Maison-Blanche, sur trois plans prioritaires.

« Ces engagements, que les compagnies prennent dès maintenant, reposent sur trois principes fondamentaux : la sûreté, la sécurité et la confiance. »

– Président Joe Biden

« Ces engagements, que les compagnies prennent dès maintenant, reposent sur trois principes fondamentaux : la sûreté, la sécurité et la confiance », a précisé le président, rappelant l’importance de couvrir tous les angles morts du développement des technologies avant de les démocratiser.

1. S’assurer de la sûreté des produits avant de les mettre en marché

Les entreprises ont ainsi accepté de se soumettre à des tests, qui seront partiellement réalisés par des experts indépendants pour prévenir les risques majeurs liés au développement de l’IA. Ces mesures préventives auront pour objectif de renforcer la biosécurité et la cybersécurité des produits développés en IA, et ce, avant leur commercialisation.

Les grands joueurs de l’industrie devront aussi faire preuve de transparence avec les gouvernements, la société civile et le milieu académique quant à la gestion des risques anticipés. « Cela inclut l’adoption des meilleures pratiques de sécurité, la divulgation de toute tentative de contournement des mesures de sécurité, et la collaboration technique », indique l’administration Biden.

2. Concevoir des systèmes en mettant la sécurité au premier plan

Les entreprises s’engagent également à investir dans la cybersécurité de leurs systèmes contre les menaces internes, pour protéger les données propriétaires et leur souveraineté, ainsi que les modèles inédits. « Ces modèles sont des éléments constitutifs essentiels des systèmes d’IA. Certaines défectuosités peuvent persister, même après leur commercialisation, d’où l’importance d’assurer la robustesse et la fiabilité du mécanisme de transmission des informations. »

3. Gagner la confiance du public

Enfin, des mécanismes techniques ainsi qu’un système de filigrane devront être prévus pour garantir que le contenu généré par l’IA soit identifiable comme tel par les utilisateurs. « Sans freiner les élans créatifs que permettra l’IA générative, ces mesures réduiront les dangers de fraude et de tromperie », promet la Maison-Blanche.

À lire également :

Révolution éthique de l’IA : un appel à la responsabilité de tous

Crédit Image à la Une : Capture d’écran de la retransmission de la Maison-Blanche (à gauche) et photo de Mojahid Mottakin (à droite)