L’IA permettra bientôt de mieux lire les émotions ressenties par les opérateurs de drones afin de les soutenir dans le feu de l’action. C’est ce que nous avons appris lors d’une conférence donnée dans le cadre du RDV Forum 2021 organisé par le Consortium de recherche et d’innovation du Québec (CRIAQ).

Tout comme les contrôleurs aériens, les opérateurs de robots aériens de la Défense nationale sont quotidiennement bombardés d’information. Leur charge émotive ou leur fatigue influencent leur performance et augmentent le risque d’erreur.

Malgré une diminution du nombre d’opérateurs aux commandes des drones et des aéronefs télécommandés UAV (Unmanned Aerial Vehicle), les facteurs humains demeurent au cœur des préoccupations concernant la sécurité des vols.

Pourquoi? Parce que – même si les robots aériens sont de plus en plus autonomes – il reste que leur entrainement, lui, se complexifie. Ce qui signifie des périodes de contrôle plus longues ainsi qu’une supervision de la part de plusieurs opérateurs consécutifs (risque accru d’erreur).

Illustration d’une salle d’opérateurs de drones

En fait, les facteurs humains représentent plus du deux tiers (2/3) des causes d’incident ou d’accident d’UAV, selon les études citées[I][II] par Mohamed Dahmane, du Centre de recherche de l’institut de Montréal (CRIM).

« Une surveillance continue de l’état émotionnel et du stress des opérateurs permettrait de limiter la surcharge mentale durant les longues périodes de travail et minimiserait les occasions d’erreurs critiques. » – Mohamed Dahmane, chercheur au CRIM.

L’INFORMATIQUE AFFECTIVE

La majorité des techniques pouvant monitorer le niveau de stress se font par des indicateurs physiques jugés intrusifs et non applicables sur l’ensemble des opérateurs : capteurs biométriques de fréquence cardiaque, analyse sanguine, suivi des yeux, conductance de la peau, etc.

Cependant, avec les récentes avancées en intelligence artificielle (IA) et la vision par ordinateur, de nouveaux indicateurs psychologiques sont en train de voir le jour. Les chercheurs tentent de combiner l’analyse des émotions faciales et de la voix pour évaluer l’état émotionnel de l’opérateur.

COMMENT MODÉLISER UNE ÉMOTION ?

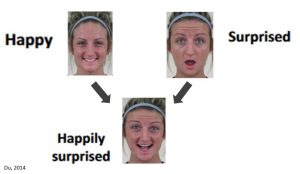

En vision par ordinateur, les émotions étaient d’abord séparées en 7 groupes d’émotions primaires avec le système Categorical. Puis un autre système de reconnaissance FACS a permis de reconnaître les émotions composées, comme l’heureuse surprise.[III]

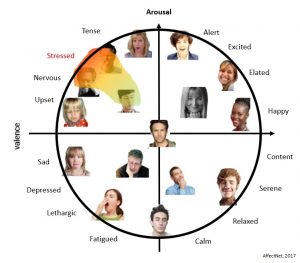

Mais pour détecter le stress, un autre système est venu ajouter deux nouvelles dimensions aux modèles linéaires. La dimension de la Polarité (Valence positive ou négative) et celle de l’Intensité (Arousal) pour représenter les émotions en 2D.[IV]

Le 3e système présentement à l’étude est encore plus complet. Il s’agit d’un modèle 4D qui ajoutera les dimensions de la Dominance et celle de l’Anticipation pour détecter une émotion à travers le temps avec la vidéo et l’audio.

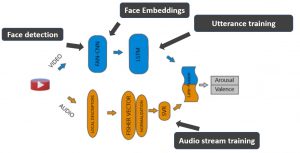

L’apprentissage profond prendrait alors en compte la bimodalité visuelle (face détection) et audio pour les modéliser (face embeddings) et en faire une utterance (un ensemble de frames qui représentent l’émotion).

On pourrait donc “lire” des émotions d’un opérateur de drone ou d’un pilote d’avion en mouvement, de la même manière que l’on peut lire des lettres pour ensuite former un mot.

Par conséquent, l’intégration de l’IA pourrait permettre d’évaluer rapidement et adéquatement les dispositions émotives de l’opérateur, incluant le stress, la fatigue, la surcharge cognitive, l’engagement, mais aussi la confiance de l’opérateur dans la machine en plus des émotions comme la joie, la frustration et la colère.

INTERACTION HUMAIN-MACHINE

Qui plus est, l’IA pourrait limiter l’impact des facteurs humains sur les incidents critiques et même optimiser la collaboration entre l’opérateur et le drone.

Une fois l’émotion de l’opérateur détectée, elle serait prise en compte par le système intelligent. Le comportement d’un opérateur pourrait ainsi déclencher certaines actions automatiques. [V]

Par exemple, lorsque l’opérateur est plus surchargé ou stressé, l’IA pourrait déclencher une automatisation, comme celle d’enlever des écrans ou des informations moins pertinentes. Ceci aiderait l’humain à mieux focaliser sur les informations pertinentes dans le but d’augmenter la sécurité et de diminuer les erreurs.

AUTRE NOUVEAUTÉ

Par ailleurs, nous avons appris qu’une nouvelle plateforme intelligente de certification, Smart-PC, figurait parmi les autres projets innovants accompagnés par le CRIAQ et ses partenaires.

Cette plateforme pilotée par CS Canada (leader dans le design et les tests de logiciels critiques) vise à démocratiser la certification des technologies pour les systèmes autonomes en développant des algorithmes pour trier et organiser les données. Rappelons que ces certifications posent souvent des barrières à l’intégration de l’IA dans cette industrie.

Le groupe est à la recherche d’une jeune pousse pour concrétiser cette idée de projet. À qui la chance?…

Sources citées :

[I] Étude Williams, 2004, portant sur le US-predators : 67% d’erreurs commises par le facteur humain.

[II] Étude Tvaryanas, 2005 et DAG, 2013 : Près de 70% d’incidents dus aux facteurs humains dans les forces de l’Air, près de 60% dans les Marines et près de 35% dans l’Armée de terre.

[III ] S. Du et al., Compound facial expressions of emotion. Proc. of the National Academy of Sciences, 111(15), 2014.

[IV] A. Mollahosseini et al., AffectNet: A Database for Facial Expression, Valence, and Arousal Computing in the Wild, IEEE Trans. on Affective Computing, 2017.

[V] Mathematics of Autonomy, Mathematical Methods for Cyber-Physical-Cognitive Systems, Ivancevic, 2017.