Au Québec comme ailleurs, les dérives de l’intelligence artificielle et de l’hypertrucage se multiplient. Bien que le contenu artificiel pullule depuis des années sur le web, la société, et plus particulièrement les personnalités de la sphère publique, semblent soudainement frappées d’une prise de conscience de la menace que peut représenter ce type de technologie. Plus à la traîne encore que ce constat, les mesures d’encadrement que font miroiter les élus et institutions manquent cruellement à l’appel pour reprendre le contrôle du développement de l’IA et en assurer le maintien responsable. Est-il trop tard pour dompter la bête?

Des vedettes québécoises imitées pour mieux arnaquer

Nathalie Simard tire la sonnette d’alarme

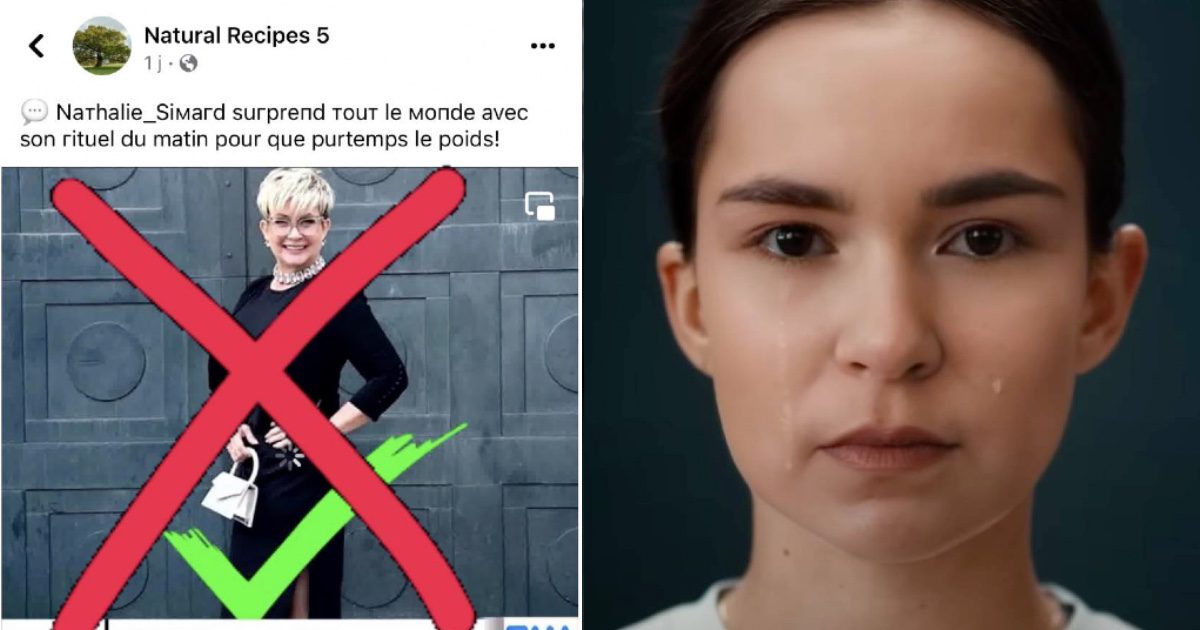

Il y a quelques jours, la chanteuse Nathalie Simard a annoncé qu’elle était victime d’une fausse publicité imitant sa voix et son image, dans le but de vendre un produit pour la perte de poids.

La publicité a été réalisée au moyen de l’hypertrucage, une technique d’intelligence artificielle popularisée sous le terme « deepfake ». Cette méthode de synthèse multimédia repose sur l’IA afin de reproduire et s’approprier la voix ou le visage de quelqu’un, en entraînant des algorithmes à partir d’une banque d’images et d’enregistrement originaux.

« C’est clair que je vais faire des démarches auprès des autorités policières. Je vais voir, aussi, comment on peut faire pour que ça arrête, cette mascarade, ce cirque, parce que là, ça va loin (…) Vous devez être vigilants car vous aussi pouvez vous faire prendre! »

– Nathalie Simard, chanteuse québécoise

« Je suis un peu découragée. C’est d’une importance capitale, honnêtement, parce que ce qui se passe n’est vraiment pas drôle (…) vous allez voir jusqu’où c’est rendu, la technologie. Là, c’est rendu que grâce à l’intelligence artificielle, (des fraudeurs) ont recréé mon timbre de voix, et me font dire des choses que je n’ai jamais dites, que je n’ai jamais approuvées. Alors, c’est grave, ça va loin. C’est clair que je vais faire des démarches auprès des autorités policières. Je vais voir, aussi, comment on peut faire pour que ça arrête, cette mascarade, ce cirque, parce que là, ça va loin (…) Vous devez être vigilants car vous aussi pouvez vous faire prendre! », a finalement lancé Mme Simard, dans une vidéo diffusée sur les réseaux sociaux, se voulant à la fois un cri du cœur et une mise en garde.

Les journalistes comme cible

Rappelons qu’il y a quelques mois, une publicité frauduleuse se servait du deepfake vocal de la journaliste et animatrice Anne-Marie Dussault pour faire la promotion d’une application de casino. Lorsqu’un internaute cliquait sur l’annonce, il voyait apparaître une roue de fortune, programmée pour le faire gagner jusqu’à l’y rendre accro.

L’empreinte digitale : l’identité partagée sans modération

C’est que plus l’empreinte digitale d’un individu est présente sur le web, plus il y a de contenu multimédia pour l’identifier et nourrir une base de données généreuse pour l’IA, faisant de lui une cible idéale pour l’usurpation.

Une personnalité connue, dont l’image et la voix sont activement diffusées et partagées sur le web, s’expose donc davantage au risque d’être imitée par l’IA et de voir son identité visuelle et vocale lui échapper.

Les enfants exposés au risque

Étant donné que les deepfakes sont générés à partir de grandes quantités d’images et de data, ils soulèvent également des inquiétudes quant au contenu partagé par les internautes qui ne sont pas nécessairement issus du vedettariat, mais qui ont tout simplement l’habitude de publier leurs propres photos ou celles de leurs enfants de façon récurrente sur les réseaux sociaux.

L’enfant de cinq ans moyen a, à son actif, 1500 images à son effigie sur les réseaux sociaux.

– The Telegraph

Selon une récente étude du quotidien The Telegraph, un enfant âgé d’environ cinq ans compterait à lui seul pas moins de 1500 images à son effigie sur les réseaux.

Pour faire réfléchir les parents aux conséquences possibles d’une telle présence de leur enfant sur le web, la société de télécommunications Deutsche Telekom a dévoilé une campagne de sensibilisation créative et poignante, réalisée en partenariat avec l’agence adam&eveDDB, qui met en vedette le personnage d’Ella, s’adressant à ses parents : « Salut maman, salut papa, c’est moi, Ella… ou plutôt, une version digitale de moi, un peu plus vieille. C’est fou ce que la technologie peut faire aujourd’hui, n’est-ce pas ? On n’a besoin que de quelques photos, comme celles que vous partagez de moi sur les réseaux sociaux, qui peuvent être téléchargées et utilisées par n’importe qui. Je sais que pour vous, ces photos sont des souvernirs. Mais pour d’autres, ce sont des données. Et pour moi, qui sait, peut-être le début d’un avenir horrible… »

Les risques liés à la perte d’emploi

L’IA générative et reproductrice soulève aussi de plus en plus de questions éthiques d’ordres professionnel et commercial quant aux nouveaux moyens de production et de création, notamment parce qu’elle peut faire perdre des emplois et des revenus à plusieurs artisans.

Dans l’industrie du jeu vidéo, le cas d’usurpation dont a été victime l’actrice britannique Victoria Atkin en atteste. Il y a environ deux mois, celle qui est connue pour être la voix qui double le personnage d’Evie Frye du jeu Assassin’s Creed Syndicate, développé au Québec par Ubisoft, a dénoncé l’usage non-autorisé de sa voix sur Nexus Mods, un site très populaire où les gamers (amateurs de jeux vidéo) peuvent télécharger ce qu’on appelle des « mods », soit des ajouts ou des modifications qui peuvent bonifier leur expérience d’un jeu vidéo. En tant que contributeur de la plateforme, un créateur de la communauté a sollicité l’IA pour imiter la voix de Mme Atkin, puis en a fait un mod, qu’il a par la suite offert en téléchargement sur la plateforme, permettant ainsi à des centaines d’intéressés de télécharger la voix de l’actrice et d’en faire une narratrice de leur jeu, sans son autorisation et sans qu’elle n’ait touché de redevances.

Pour Mme Atkin, ce qui est d’autant plus inquiétant, c’est que bientôt, ce sont les développeurs des jeux eux-mêmes qui n’auront plus qu’à utiliser l’IA pour générer des voix, imitant ou remplaçant celle des acteurs, sans avoir à les rémunérer ou les engager pour faire du doublage.

Mais en attendant, ce genre de pratique se veut déjà bien répandu dans le secteur du divertissement, dans un contexte d’activité illégale ou non-encadrée visant à faire du trafic de masse. Pensons aux applications d’IA qui permettent d’imiter la voix d’artistes musicaux pour en faire les interprètes de morceaux auxquels ils n’ont jamais consenti à prêter leur voix…

Des solutions

Être en mesure d’identifier les deepfakes

Avant de filtrer ou d’interdire du contenu usurpateur destiné à tromper, l’enjeu est souvent de reconnaître les deepfakes, puisqu’ils sont de plus en plus réalistes. Des entreprises de cybersécurité proposent déjà des mesures de détection visant à identifier tout contenu relevant du deepfake, grâce à des algorithmes performants. Analysant ainsi l’image vidéo, ils peuvent détecter, par exemple, le mouvement saccadé, la variation de lumière d’un plan à un autre, les clignements étranges du visage, et les défauts de synchronisation entre les lèvres et la parole.

Mais l’autre problème, c’est que même si le contenu artificiel est identifiable, si aucune mesure légale ne pousse la plateforme ou le diffuseur à le retirer de l’espace public ou de sa programmation, il continuera probablement d’exister, puis d’être visionné et, dans biens des cas, de déplaire à ceux qu’il personnifie, comme c’est le cas pour la série Deep Fake Neighbour Wars, diffusée en toute légalité par la chaîne télé ITV.

Encadrer les usages des deepfakes

C’est donc qu’il faut s’attarder à établir et uniformiser les réglementations manquantes quant aux deepfakes, pour en encadrer et en limiter les usages. Or, la technologie se développe à un rythme trop effréné pour l’appareil législatif.

« L’IA arrive à nos portes à une vitesse fulgurante, avec des propositions pratiques et concrètes qui vont changer la société et nos comportements, mais on n’est pas prêts en termes de gouvernance », amène Jonathan Bélisle, directeur du design de Prodago, un logiciel qui aide les dirigeants et leurs équipes à concevoir et déployer une gouvernance des données et de l’IA unifiée.

« Il n’y a pas vraiment d’encadrement en matière de gouvernance de données dans les projets d’IA, en ce moment. Des notions et mesures de gestion de data, d’éthique et de confidentialité existent, mais la régulation des lois internes et externes commence tout juste à pointer le bout de son nez. On le voit, notamment, avec la Loi 25, maintenant en vigueur », ajoute M. Bélisle, faisant référence à la réforme qui modernise les règles protégeant les renseignements personnels au Québec.

Crédit Image à la Une : À gauche, la publicité frauduleuse tirée de la page Facebook de Nathalie Simard – Officiel. À droite, une capture d’écran du film de Deutsche Telekom et dam&eveDDB.

À voir également :

[Émission C+clair] Peut-on faire confiance à l’intelligence artificielle ?