Le changement climatique est une crise mondiale de notre temps, qui se manifeste de multiples façons selon les régions géographiques. Cependant, la sensibilisation autour de cette problématique est confrontée au défi de l’intangibilité: la plupart des impacts ne sont pas visibles dans notre vie quotidienne.

Afin de sensibiliser aux conséquences désastreuses du changement climatique, le projet Visualiser le changement climatique de Mila, en collaboration avec Ubisoft La Forge, vise à comparer l’efficacité de deux jeux de données d’images créés synthétiquement utilisés pour former des modèles d’IA, en particulier des réseaux d’adversaires génératifs (GANs). La tâche était de générer des inondations à des fins de visualisation des effets du changement climatique.

En général, les GANs sont des réseaux de neurones très gourmands en données et nécessitent des dizaines de milliers d’images pour former un bon modèle capable de générer des résultats réalistes. La quantité de données réelles à disposition étant insuffisante, la décision fut prise de créer des données synthétiques pour augmenter l’ensemble d’entraînement initial. Un jeu de données a été créé avec le moteur de jeu Unity3D et le second avec celui de Watch_Dogs2.

Dans ce monde virtuel, des inondations ont été simulées avec des effets d’eau réalistes et des images appariées ont été prises (inondées et non inondées) du même endroit. Ces types d’images jumelées peuvent aider les GANs à «comprendre» ce qu’est une inondation pendant le temps de formation et donc, espérons-le, à générer des images «inondées» du monde réel.

Fig 2. Image synthétique tirée de Watch_Dogs2, a) avec inondation, b) pas d’inondation, c) référence dans le monde réel, d) même endroit dans Google maps.

Au total, 500 images synthétiques uniques furent créées depuis le monde virtuel construit dans Unity3D et 500 à partir de Watch_Dogs2. Ce dernier environnement est environ 48 fois plus grand que celui de Unity3D. En résulte un ensemble de données beaucoup plus grand. Une version réduite du futur jeu de données est publiée sur GitHub.

Ces images combinées avec 3800 les images du monde réel forment quatre GANs différents avec les entrées suivantes:

Images réelles et U3D

Images réelles et WD2

Images réelles, WD2 et U3D

Seulement des images réelles

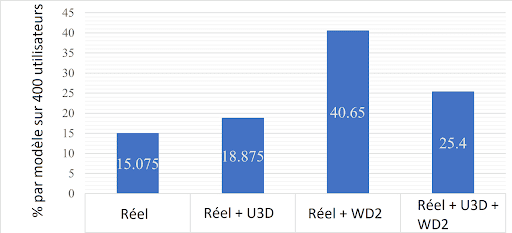

La meilleure façon de comparer les images générées est l’évaluation humaine. Pour vérifier les résultats des images synthétiques, des participants ont été soumis à un test à l’aveugle très simple. Ceux-ci choisissaient par clic leur version préférée de l’image inondée. Ont été soumises 10 images tests différentes avec 4 options inondées chacune, toujours randomisées.

Les tests préliminaires à l’aveugle en interne montrent que 85% des participants préfèrent les images générées par les GANs formés à l’aide d’images synthétiques supplémentaires par rapport au modèle qui a été formé uniquement sur des images du monde réel.

Il est facile de remarquer que le modèle formé avec des images Real + WD2 peut générer des inondations d’une manière beaucoup plus réaliste que les autres modèles. Plus de 40% des images préférées des participants sont générées par ce modèle. En conséquence, les images WD2 permettent de meilleurs GANs! Ainsi, le modèle est perfectible avec plus d’images et de fonctionnalités de l’environnement WD2.

Il est intéressant de noter que la qualité des images résultantes est détériorée avec l’ajout d’images Unity3D en entrée. Un conflit entre différentes sources d’images pourrait entraîner un tel résultat. Cependant, un examen plus approfondi serait nécessaire.

Enfin, les différences de résultats entre WD2 et U3D indiquent que tous les ensembles de données synthétiques ne peuvent être placés sur le même podium en matière de qualité.