À l’heure où l’on s’interroge sur le racisme systémique dans toutes les strates de notre société, la question ressurgit dans le monde de l’intelligence artificielle. L’IA reflète le mode de pensée des humains qui la conçoivent et renvoie toutes leurs discriminations.

Il est bon de rappeler que les intelligences artificielles ne sont pas des humanoïdes doués de libre-arbitre mais une combinaison d’algorithmes qui essaient, au mieux, d’imiter le fonctionnement du cerveau humain. « Elles ont moins de sens commun qu’un rat », déclarait en 2018, Yann LeCun, le directeur des recherches en intelligence artificielle chez Facebook. Elles sont codées par des humains et apprennent à partir de gigantesques bases de données générées par notre société et de ce fait, les IA révèlent son racisme systémique.

Les algorithmes et leurs biais

Une IA ne connaît que ce qu’on lui montre. Si un algorithme est entraîné à reconnaître uniquement des visages de personnes blanches, parce qu’on ne lui soumet que des images de personnes blanches par exemple, il ne peut pas savoir qu’il existe aussi des personnes qui ne sont pas blanches. Ou alors, il les considère comme une donnée « anormale », c’est-à-dire pas dans la norme de ce qu’il connaît. Or, les bases de données utilisées pour alimenter les plateformes montrent majoritairement des personnes non-racisées.

Les intelligences artificielles prennent de plus en plus de place dans notre quotidien, que ce soit pour automatiser des tâches répétitives ou encore pour traiter de grandes quantités de données. Et ce, dans des domaines aussi sensibles que la justice, les ressources humaines ou encore l’information.

Une affaire illustre bien ce phénomène. En janvier dernier un afro-américain est arrêté à tort à Détroit et passe 30 heures en détention. Tout ça parce qu’un logiciel a fait une corrélation entre la photo de son permis de conduire et l’image d’un voleur de montres capturé par des caméras de surveillance. Mais est-ce que cela aurait pu arriver avec quelqu’un appartenant à une autre ethnie ? Pas vraiment.

Une étude du MIT, parue en février 2018, révèle une forte disparité de la reconnaissance faciale selon l’ethnie et le genre de la personne analysée. Les principaux logiciels de reconnaissance faciale ont une marge d’erreur de moins de 1% pour les hommes blancs, contre 35% pour les femmes noires.

La polémique suscitée par l’usage des technologies de reconnaissance faciale dans le cadre du maintien de l’ordre aux Etats-Unis, ainsi que les biais inhérents à ces technologies, ont fait réagir les acteurs du secteur. Microsoft a annoncé l’arrêt de la commercialisation de ses outils de reconnaissance faciale auprès de la police, tandis qu’Amazon a décrété un moratoire d’un an sur le sujet et que IBM a tout simplement annoncé l’abandon de ses recherches sur le sujet.

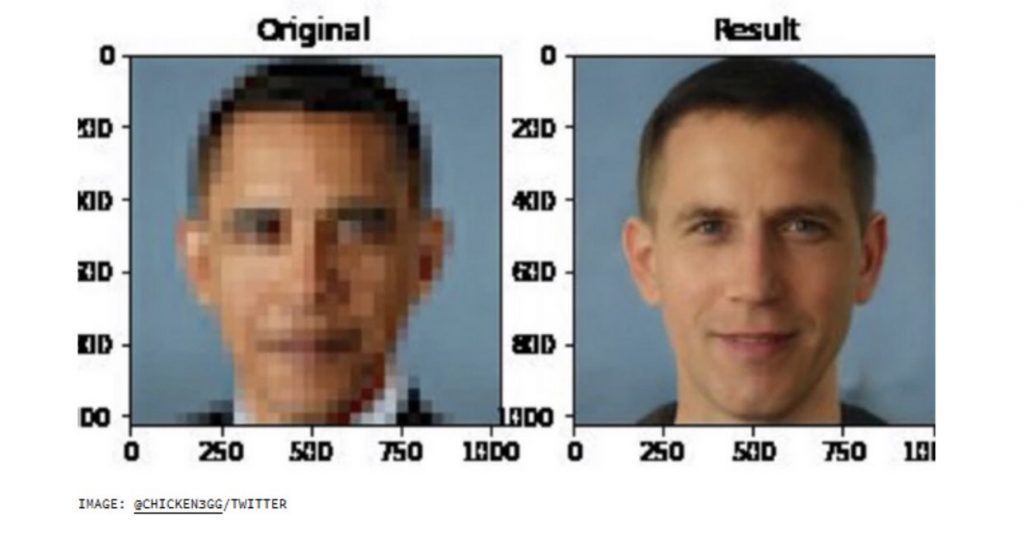

L’IA véhicule tous les préjugés racistes ancrés dans notre société et les exemples sont légions. Algorithm Watch a démontré que, confronté à des images d’individus tenant un thermomètre frontal, le programme d’analyse d’images Google Vision reconnaît des «jumelles» dans une main à peau blanche, mais identifie «un pistolet» dans la main à peau noire. Selon l’OBNL allemande, ce biais est «probablement dû au fait que les images utilisées dans la base de données qui comportaient des personnes noires étaient plus souvent associées à la violence que celles avec des personnes blanches.» Google a reconnu auprès d’Algorithm Watch un résultat «inacceptable». Ou encore un autre exemple, lorsqu’un programme d’IA est devenu jury d’un concours de beauté, en septembre 2016, il a éliminé la plupart des candidats noirs. Plus récemment encore, une polémique a éclaté en juin dernier sur Twitter autour du programme PULSE, une IA de reconstitution d’images. Denis Malimonov, un programmeur russe, a eu l’idée de créer Face Depixelizer, une application de défloutage des visages basée sur PULSE. En testant l’application les internautes ont découvert qu’elle arrive à bien reconstituer le visage de Mario mais que les portraits de Barack Obama, de Mohamed Ali ou encore de Lucy Liu étaient reconstitués en version « blanche ».

Le portrait de Barack Obama reconstitué par l’IA de Face Depixelizer.

Malheureusement, les exemples comme ceux-là foisonnent. Alors comment éviter qu’une IA devienne raciste?

Une première solution serait que les équipes qui les programment soient plus diversifiées et inclusives. À l’heure actuelle, ceux qui programment ces IA sont majoritairement des hommes blancs : « Un peu comme un humain, un robot ne naît pas raciste ; il apprend à le devenir. Et cela peut se produire malgré les bonnes intentions de ses créateurs. Ils peuvent avoir l’impression que leur base de données est représentative, alors qu’elle ne comprend en réalité que des gens qui leur ressemblent », explique Abhishek Gupta, ingénieur logiciel et fondateur du Montreal AI Ethics Institute, un groupe de recherche sur le développement éthique de l’intelligence artificielle, dans une entrevue au magazine “L’actualité”.

Il faudrait également s’attaquer aux bases de données qui servent à l’apprentissage des machines. Mais la tâche s’avère titanesque, car il faudrait intervenir sur des corpus constitués de millions, voire de milliards d’éléments, partagés par des compagnies dans le monde entier. De plus, si l’objectif de ces programmes d’IA sont de comprendre l’interprétation du monde par les êtres humains, modifier les données pourrait fausser ses résultats. Comme le rappelle Sandra Wachter, chercheuse en éthique des données et des algorithmes à Oxford, dans le Guardian : « Les humains, eux, peuvent mentir sur les raisons pour lesquelles ils n’embauchent pas quelqu’un. À l’inverse, les algorithmes ne mentent pas et ne nous trompent pas. » La solution la plus cohérente ne serait-elle pas de changer notre société pour qu’elle inclut enfin toute la diversité des gens qui la compose ?